[大带宽]数据中心主干网络有必要升级到400G么?

数据中心行业对400G网络的关注度正在迅速上升。与此同时,许多传统数据中心的用户非常困惑:一些传统数据中心的支柱刚刚从10G/40G上升到100G。真的有必要去400G吗?

自2010年以来,不同类型数据中心的需求呈现出不同的趋势,需求水平多样化。用户选择不同带宽的应用程序是基于业务类型的合理选择。作者认为,目前对数据中心400G应用程序的需求相对迫切。

超大规模数据中心

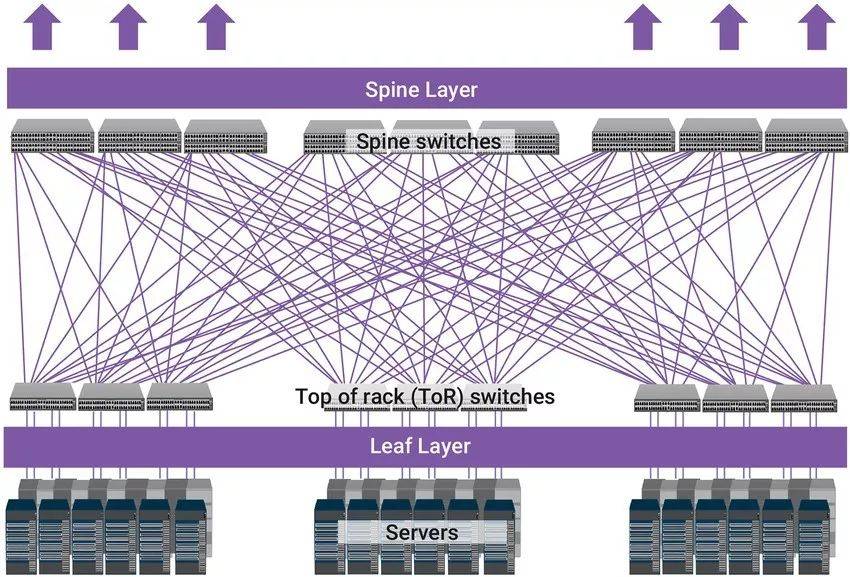

超大型数据中心需要大量的连接,因为每个Leaf与Spine完全连接,最大限度地实现交换机之间的无阻塞网络连接。数据中心的硬件加速器、人工智能和深度学习功能消耗高带宽,迫使高端数据中心快速转向下一代以更高的数据速度运行的连接。

400g在超大规模数字中心的网络叶脊架构互连应用将具有重要意义。与大量100g互连相比,400g接口不仅可以简化网络架构,还可以降低同等速度应用的成本和单位流量的功耗。超大型数据中心,特别是叶脊架构网络,对400g具有现实意义和紧迫性。

DCIII数据中心互连

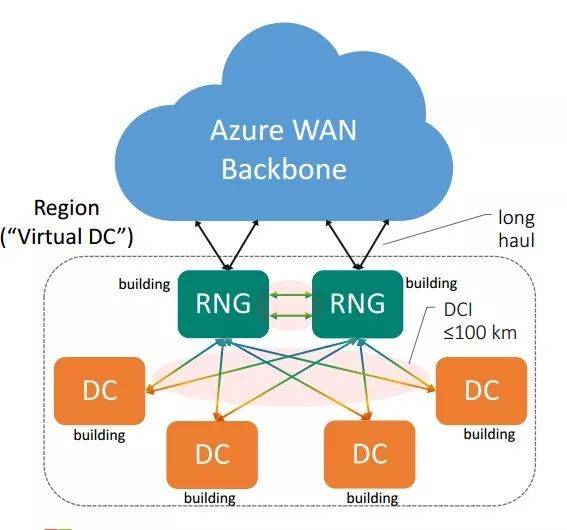

随着数据流量的爆炸性增长,数据中心网络逐渐走向IP互联网的中心。目前,数据中心不再局限于一个或几个机房,而是一组数据中心集群。为了实现网络业务的正常运行,这些数据中心需要协调运行,需要及时交互大量信息,导致DCI网络需求。

云业务从根本上改变了计算模型和流量模型。网络流向从传统意义上的南北流向IDC或资源池之间的水平流。数据中心之间水平流量的比例正在逐渐增加,这就要求数据中心互联网具有大容量、无阻塞、延迟低的特点,带宽成为DCI建设的主要焦点。

对于大型数据中心,为了接近客户,提供更好的服务体验,或数据中心之间的灾难,这些数据中心可能分布在同一公园,或同一城市的不同地区,甚至不同的城市,通常数据中心之间的距离在500米到80公里之间。

连接芯片到芯片和芯片到模块

芯片是芯片(C2C)和芯片对模块(C2M)最简单的互连形式。芯片到芯片的电气接口位于同一PCB平面上的两个IC之间,芯片到模块的接口位于端口ASIC和具有信号调节IC的模块设备之间。IEEE802.3根据不同类型光学模块的每个通道50GB/s电气,定义了连接单元接口(AUI)。根据连接长度和吞吐量的要求,网络实施者可以选择不同的芯片将光学模块连接到模块接口。

硅光子技术是与芯片相互连接的驱动力之一。硅光子技术是基于硅和硅基底衬底材料(如SGE/SI材料SOIC芯片),结合超大规模、超高精度制造的特点,结合光子技术超高速、超低功耗的优点,是应对摩尔定律故障的颠覆性技术。

在硅光子产业发展规划中,该产业已进入快速发展时期。与目前的状态相比,硅光子技术在每秒峰值速度、能耗和成本方面分别提高了8倍,降低了85%,降低了84%。硅光子以传播速度快、功耗低的特点,已成为超级计算市场的重要研究方向。

随着数据中心核心网络设备之间传输速率的不断提高,芯片(C2C)和芯片到模块之间的优秀技术特性和商业价值将从400G、800G甚至1.6T中更加显现。